8. Juli 2025 von Sebastian Lang und Christian Wagner

Snowflake Openflow: Datenintegration der nächsten Generation

Mit der Einführung von Snowflake Openflow, das auf Apache NiFi basiert, erweitert Snowflake seine Plattform um einen leistungsstarken Dienst zur Datenintegration. Als Elite-Partner wurde adesso ausgewählt, um dieses innovative Produkt exklusiv vorab zu testen und zu evaluieren.

Was ist Snowflake Openflow?

Snowflake Openflow ist eine vollständig in die Snowflake-Plattform integrierte Lösung zur cloud-basierten Datenintegration. Sie basiert auf der populären Open-Source-Software Apache NiFi, die für ihre Benutzerfreundlichkeit bei komplexen Datenintegrationen bekannt ist. Damit können sowohl strukturierte sowie unstrukturierte Daten wie Dokumente, Audio- oder Sensordaten in nahezu Echtzeit integriert werden. Unternehmen sind somit in der Lage, effizient und sicher Datenströme zu orchestrieren, transformieren und verwalten.

Technischer Hintergrund: Apache NiFi trifft Snowflake

Apache NiFi wurde ursprünglich von der NSA entwickelt und ist auf die Automatisierung des Datenflusses spezialisiert. Dabei wurde großes Augenmerk auf die Sicherheit und Nachverfolgbarkeit der verarbeiteten Daten gelegt. Die Software zeichnet sich durch ihre benutzerfreundliche Drag-and-drop-Oberfläche und ihre Fähigkeit aus, Datenflüsse in Echtzeit zu überwachen und zu verwalten. Apache NiFi unterstützt zahlreiche Konnektoren und Prozessoren, die die Integration unterschiedlichster Datenquellen und Zielen ermöglichen.

Snowflake Openflow nutzt diese Vorteile und integriert sie nahtlos in die bestehende Snowflakes-Infrastruktur. Openflow bietet vordefinierte Konnektoren, etwa für Microsoft Dataverse, Kafka, Google Drive, Slack, Oracle, Jira, MySQL und viele weitere, wodurch sich der Datenfluss erheblich vereinfacht. Die Konnektoren folgen strengen Designprinzipien, um Performance, Fehlertoleranz und einfache Konfigurierbarkeit sicherzustellen. Dank dieser Out-of-the-box-Sicherheit und -Wartbarkeit wird Openflow unternehmenstauglich und unterstützt zudem die Einhaltung von Governance- und Compliance-Vorgaben durch transparente Nachverfolgbarkeit und Datenhoheit.

Die High-Level Architekturmodelle

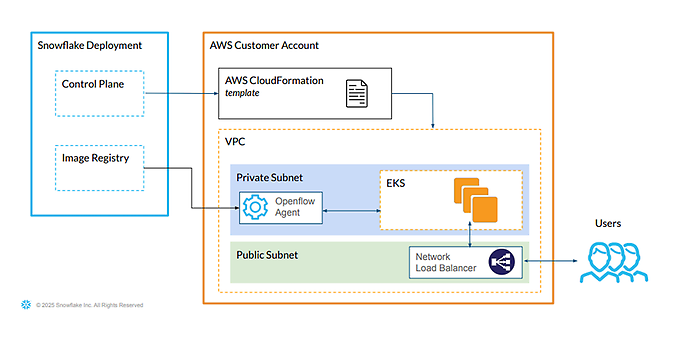

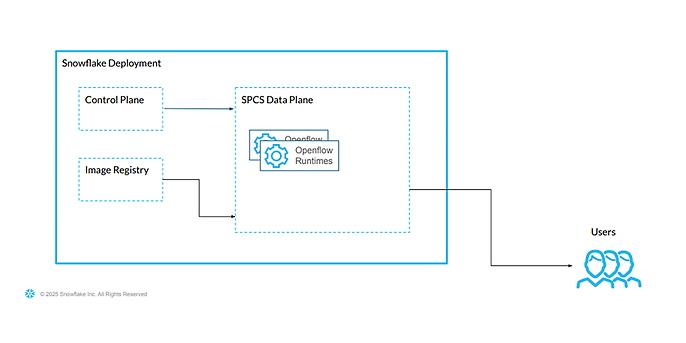

Openflow kann entweder in der eigenen Cloud-Umgebung (BYOC, „bring your own cloud”), aktuell auf AWS, oder demnächst direkt über den Snowpark Container Service (SPCS) betrieben werden. In beiden Fällen liegt die Control Plane, also der Kontroll- und Steuerraum für die Openflow Pipelines, innerhalb von Snowflake. Die Data Plane, der Maschinenraum, liegt bei der BYOC-Variante im jeweiligen eigenen Cloud-Account, bei Realisierung über SPCS im eigenen Snowflake-Account. Dadurch ergeben sich unterschiedliche Kostenstrukturen.

Openflow High Level Architecture (BYOC)

Openflow High Level Architecture (SPCS)

Beide Varianten bieten unterschiedliche Vorteile:

- BYOC ermöglicht es Unternehmen, Openflow vollständig in ihrer eigenen AWS-Infrastruktur zu betreiben. Über ein bereitgestelltes CloudFormation-Template wird eine Umgebung mit einem Openflow-Agenten (EC2) in einem privaten Subnetz sowie einem EKS-Cluster für die Flow-Ausführung eingerichtet. Die Kommunikation mit Snowflake erfolgt über die Control Plane und das Image Repository. Nutzende greifen über einen Network Load Balancer auf das System zu. So behalten Unternehmen volle Kontrolle über Ressourcen, Netzwerk und Sicherheit.

- SPCS hingegen ist eine vollständig verwaltete Variante, die direkt innerhalb der Snowflake-Plattform ausgeführt wird. Die Openflow-Runtimes werden im SPCS Data Plane bereitgestellt, ohne das eigene Cloud-Ressourcen benötigt werden. Dadurch ist Openflow besonders schnell einsatzbereit, wartungsarm und ideal für Unternehmen, die eine vollständig integrierte Lösung bevorzugen.

adesso unterstützt Snowflake bei der Einführung von Snowflake Openflow

Als Snowflake Elite Partner unterstützt adesso aktiv die Einführung von Snowflake Openflow, der neuen Plattformlösung für moderne, cloud-basierte Datenintegration. In einer exklusiven Partnerschaft testet und evaluiert adesso Openflow bereits vor dem offiziellen Marktstart – mit dem Ziel, Unternehmen beim Aufbau skalierbarer, sicherer und KI-fähiger Datenpipelines zu begleiten.

Openflow im Einsatz: Use Case Datenmigration von MySQL nach Snowflake

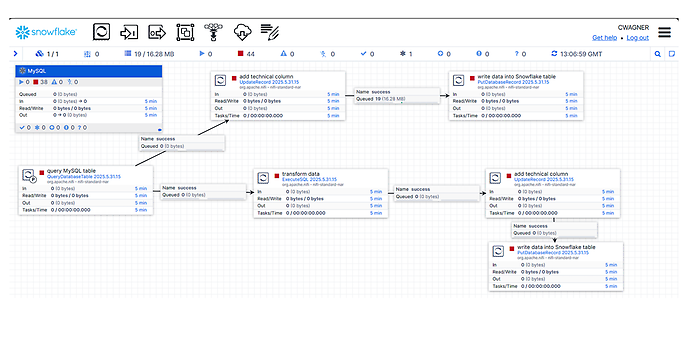

Im folgenden Praxisbeispiel lässt sich nachvollziehen, wie Openflow Datenflüsse orchestriert und dabei Transformationen bereits im Importprozess übernehmen kann. in dem hier betrachteten Use Case wird die Migration von Bankdaten aus einer MySQL-Datenbank nach Snowflake sowie die Weiterverarbeitung dieser Daten behandelt. Zum einen soll der erfolgreiche, vollumfängliche Übertrag einer originären Tabelle von einer Ursprungsumgebung (hier: MySQL) in die Zielumgebung (hier: Snowflake) erfolgen – und das bei gleichzeitiger Anreicherung der Daten um neue technische Informationen. Zum anderen sollen die Daten der originäre MySQL-Tabelle verwendet werden, um gleichzeitig in einem parallelen Verarbeitungsschritt durch Transformationen ein neues Datenprodukt innerhalb von Snowflake zu erstellen.

Nachfolgend werden die einzelnen Datenverarbeitungsschritte beschrieben.

Canvas des Use Case

Zunächst wird die Tabelle mit den Bankdaten aus einer externen MySQL-Datenbank abgefragt. Die Daten werden dabei standardmäßig von Openflow in FlowFiles im Avro-Format umgewandelt.

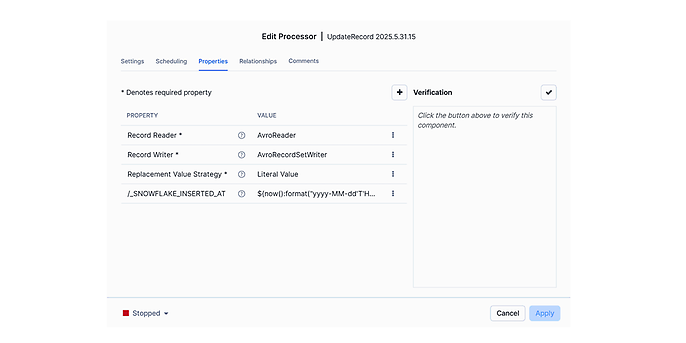

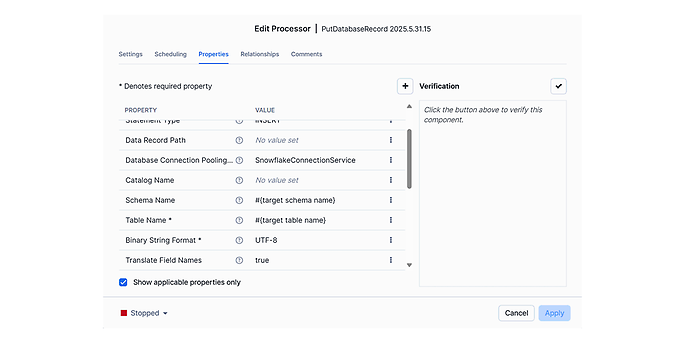

Im oberen Flow werden die extrahierten Daten nun um eine technische Spalte (_SNOWFLAKE_INSERTED_AT) erweitert, um anschließend in die Zieltabelle in Snowflake geschrieben zu werden.

Processor UpdateRecord

Processor UpdateRecord

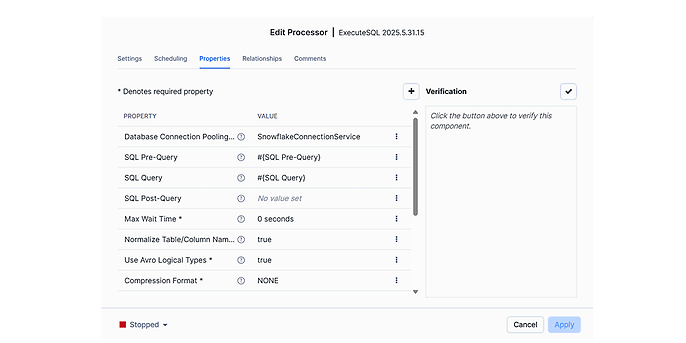

Gleichzeitig werden dieselben Daten in einem parallelen Flow (in der Canvas-Abbildung unten) transformiert und ebenfalls um eine technische Spalte ergänzt. Abschließend werden die Daten in eine neue Tabelle geschrieben, um das neue Datenprodukt zu erhalten. Im Processor ExecuteSQL findet nicht nur die Datentransformation statt, sondern es wird auch vor Ausführung der Transformation geprüft, ob die benötige Tabelle vorhanden ist. Falls nicht, wird sie neu erstellt.

Processor ExecuteSQL

Auf die Abbildungen der Processor UpdateRecord und PutDatabaseRecord wird hier verzichtet, da sie dem ersten beschriebenen Flow ähneln.

Die Verbindung zwischen den jeweiligen Processors stellen Connections dar, die die Datenflüsse zustandsabhängig (“success”, “failure”) verteilen. Innerhalb dieser Connections sind die FlowFiles sowohl vor als auch nach der Verarbeitung darstellbar, wodurch die jeweiligen Verarbeitungsschritte transparent nachvollziehbar sind.

Mehrere Processors mit ihren Konnektoren lassen sich zu individuellen Processor Groups zusammenfassen. Auf diese Weise können beispielsweise übergeordnete Steuerungsmöglichkeiten realisiert werden.

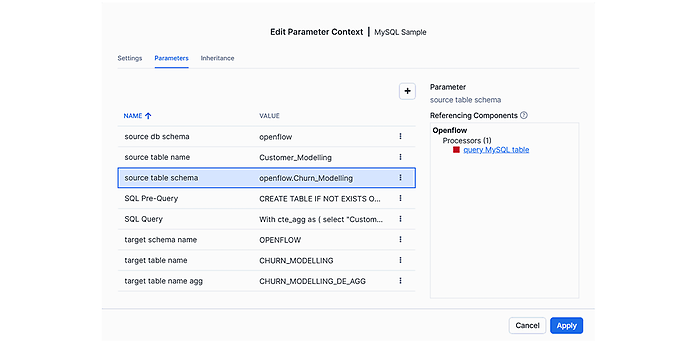

Anhand der Abbildungen ist zu erkennen, dass Parametrisierung einen hohen Stellenwert in Openflow hat. Im entsprechenden Parameter-Kontext lassen sich notwendige Anpassungen zentral und komfortabel vornehmen und die referenzierten Processors erkennen.

Parameter Context

Mit adesso die Datenintegration im KI-Zeitalter erfolgreich meistern

Als Snowflake Elite Service Partner bringen wir nicht nur über 100 Fachleute mit tiefem Branchen- und Technologie-Know-how mit, sondern beschleunigen auch komplexe ETL-/ELT-Prozesse und Governance-Vorhaben – und das schneller, kosteneffizienter und mit höherer Datensicherheit.

Das bedeutet für Unternehmen:

- Schnellere Erkenntnisgewinnung durch sofort nutzbare, qualitativ hochwertige Daten

- Entlastete Data-Teams dank automatisierter, skalierbarer Datenpipelines

- Zukunftssichere KI Projekte mit robusten Sicherheits und Compliance Standards

Mit adesso und Snowflake Openflow wird Datenintegration im KI Zeitalter nicht nur effizienter – sie wird wegweisend.

Fazit

Snowflake Openflow ist eine leistungsstarke Erweiterung der Snowflake-Plattform. Unternehmen profitieren von der benutzerfreundlichen Handhabung von Apache NiFi sowie der nahtlosen und vollständig verwalteten Integration in ihre bestehende Snowflake-Umgebung. So ist es möglich, schnell und mit geringem Aufwand erste ETL-Strecken zu implementieren. Gleichzeitig kann bei Bedarf tief in technische Details und Steuerungsmöglichkeiten eingetaucht werden. Die dabei entstehenden Kosten sind überschaubar und nicht exzessiv. Damit positioniert sich Openflow als zentrale Komponente für effiziente, skalierbare und zuverlässige ETL-Prozesse.

Wir unterstützen euch!

Ihr möchtet eure Datenintegration modernisieren und das volle Potenzial nutzen? Wir begleiten euch von der Architekturberatung bis zur Implementierung – mit fundierter Expertise, praxiserprobten Lösungen und einem starken Team. Sprecht uns an, wir zeigen euch, wie ihr eure Datenintegration skalierbar, sicher und zukunftssicher gestaltet.