5. Dezember 2025 von Mahlyar Ahmadsay und David Wedman

Implementierung von Snowflake Intelligence

Snowflake Intelligence ist jetzt für alle Accounts verfügbar und verändert die Art und Weise, wie Unternehmen auf ihre Daten zugreifen und KI nutzen. Als Elite- und Launch-Partner hat adesso Snowflake Intelligence frühzeitig intensiv erprobt, um Kunden auf ihrem Weg zur Datendemokratisierung und zur Einführung von KI-Lösungen zu unterstützen.

Dieser Blog-Beitrag beschäftigt sich nicht damit, was Snowflake Intelligence ist, da wir dieses Thema bereits ausführlich in unserem vorherigen Blog „Snowflake Intelligence: Fragt doch eure Daten“ behandelt haben. In diesem Blog-Beitrag zeigen wir, wie sich Snowflake Intelligence in bestehende Data- und AI-Landschaften implementieren lässt und geben einen kurzen Überblick über die wichtigsten Komponenten, die für die Einrichtung benötigt werden.

Überblick

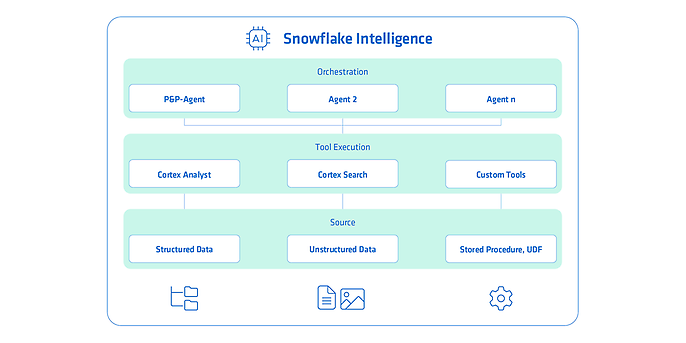

Abbildung 1: Snowflake Intelligence Überblick, Quelle: Eigene Darstellung

Als Grundlage für Snowflake Intelligence dienen verschiedene Datenquellen, die in drei Kategorien unterteilt sind: strukturierte Daten (wie Tabellen und Views), unstrukturierte Daten (beispielsweise Dokumentationen, Vertragsdaten und Richtlinien in Form von Textdokumenten, PDFs oder Bildern) sowie technische Komponenten wie Stored Procedures und benutzerdefinierte Funktionen (UDFs).

Diese Quellen werden von unterschiedlichen Services und Tools genutzt. Dazu gehören die Snowflake Cortex Services „Cortex Analyst“ und „Cortex Search“ sowie individuell entwickelte Tools. Die Orchestrierung der gesamten Datenverarbeitung erfolgt über spezialisierte Agenten (zum Beispiel P&P-Agent, Agent 2 oder Agent n), die die Ausführung und Koordination der Tools steuern.

Data Driven

Vom Datenchaos zum datengetriebenen Unternehmen

Daten sind der Motor der digitalen Transformation. Doch ohne Struktur, Strategie und sinnvolle Vernetzung bleiben sie ungenutztes Potenzial. Mit einer klaren Datenstrategie und einer modernen Architektur verwandeln wir eure Datenmassen in echten Mehrwert – für bessere Entscheidungen, automatisierte Prozesse und nachhaltige Innovation.

Use Case und Datengrundlage

In unserem Szenario begleiten wir einen Technologiekonzern, der für die Produktion elektronischer Komponenten auf Seltene Erden angewiesen ist. Mithilfe von Snowflake Intelligence sollen Mitarbeitende durch einfache Fragestellungen tiefgehende Einblicke in die strukturierten und unstrukturierten Daten des Unternehmens erhalten, ohne zuvor komplexe Analysen oder Dashboards erstellen zu müssen.

Als Grundlage für den Agenten sollen folgende Daten dienen:

Strukturierte Daten

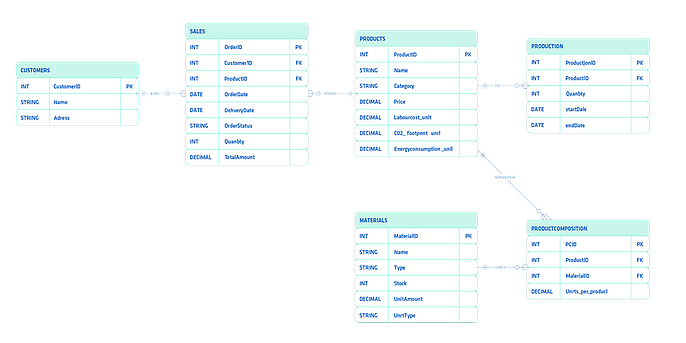

Abbildung 2: Entity‑Relationship‑Diagramm der strukturierten Daten, Quelle: Eigene Darstellung

Die Grundlage unserer strukturierten Daten bilden Produkt-, Kunden- und Sales-Tabellen sowie Produktions-, Material- und Product-Composition-Tabellen.

Unstrukturierte Daten

Die unstrukturierten Daten bestehen aus PDF-basierten Berichten zu Umwelt- und Nachhaltigkeitsanforderungen, die regulatorische Vorgaben enthalten, an die sich das Unternehmen halten muss.

Umsetzung

Um einen AI-Agenten aufzubauen, müssen wir ihm zunächst die notwendigen Services bereitstellen, auf die er zugreifen kann. Für die strukturierten Daten setzen wir einen Cortex Analyst auf und stellen ihm die Daten als Grundlage zur Verfügung. Anschließend verwenden wir den Cortex Search Service, um dem Agenten Zugriff auf die unstrukturierten Daten zu ermöglichen. In unserem Fall die Berichte zu Umwelt- und Nachhaltigkeitsanforderungen.

Erstellung des Cortex-Analysten

Um einen Cortex Analyst in Snowflake zu erstellen, beginnt man zunächst mit der Anlage des eigentlichen Cortex-Analysten-Objekts in der Snowflake-Umgebung. Anschließend wählt man aus, auf welchen Datenquellen der Analyst zugreifen soll, typischerweise Tabellen oder Views innerhalb eines Schemas. In unserem Fall sind es die im Abschnitt „Strukturierte Daten“ genannten Tabellen (Sales, Kunden, Material, etc.).

Im nächsten Schritt wird eine Semantic View für den Cortex Analyst angelegt. Diese dient als semantische Schicht über den Daten und definiert, wie der Analyst die Daten interpretieren kann. Dabei besteht auch die Möglichkeit, Beziehungen zwischen Tabellen manuell zu pflegen, sofern diese nicht automatisch erkannt werden.

Sobald alle Datenquellen angebunden und die semantische Schicht vollständig definiert ist, ist der Cortex Analyst bereit zur Nutzung. Ab diesem Zeitpunkt können bereits Fragen in natürlicher Sprache gestellt werden, die der Analyst basierend auf den verknüpften Daten beantwortet.

Erstellung des Search Services

Um einen Cortex Search Service in Snowflake zu erstellen, beginnt man damit, die relevanten Dokumente auszuwählen, die später durchsucht werden sollen (Berichte zu Umwelt- und Nachhaltigkeitsanforderungen).

Diese werden zunächst in eine Stage hochgeladen. Anschließend werden die Dokumente, beispielsweise PDF-Dateien, mithilfe der Funktion PARSE_DOCUMENT() in eine Tabelle geschrieben, wodurch der Inhalt strukturiert extrahiert wird.

Danach erfolgt das Splitten der Dokumententexte, typischerweise anhand von Überschriften oder logischen Abschnitten. Dieser Schritt dient dem sogenannten Chunking, das notwendig ist, um lange Dokumente in kleinere, semantisch sinnvolle Einheiten zu zerlegen. Dadurch kann der Search Service präzisere Suchergebnisse liefern und effizienter arbeiten.

Nachdem die Daten vorbereitet wurden, wird der Search-Service erstellt, der auf die Tabellen mit den PDF-Chunks zugreift. Abschließend wird über den Parameter Target Lag konfiguriert, in welchem zeitlichen Rahmen der Service Änderungen an den zugrunde liegenden Datenquellen übernimmt. Je nach gewählter Einstellung aktualisiert der Service seine Indexdaten regelmäßig, sodass Suchanfragen möglichst aktuelle Ergebnisse liefern.

Erstellung des Snowflake Intelligence Agents

Um einen Snowflake Intelligence Agent zu erstellen, der auf einem bestehenden Cortex Analyst und einem Search Service basiert, wird zunächst der Agent in Snowflake angelegt. Dabei werden die Datenbank, das Schema und der Name des Agents festgelegt.

Anschließend erfolgt die Konfiguration des Agents über vier Reiter:

- About: Hier definieren wir Informationen, die der Endnutzer später sieht, zum Beispiel Name, Funktionsbeschreibung und Beispielanfragen.

- Tools: Hier legen wir fest, auf welche Services der Agent zugreifen darf, etwa den Cortex Analyst, den Search Service oder eigene Custom Tools. Diese stellen Funktionen und Prozeduren bereit, die der Agent ausführen kann. Für jeden hinzugefügten Service wird eine Beschreibung hinterlegt, damit der Agent dessen Funktion versteht und entsprechend korrekt darauf zugreifen kann. Dadurch lässt sich das Verhalten des Agents gezielt steuern und sicherstellen, dass Anfragen sinnvoll verarbeitet werden.

- Orchestration: In diesem Reiter wählen wir das zu verwendende Modell aus. Beispielsweise GPT-5 oder Claude Haiku 4.5. Zudem können hier Anweisungen hinterlegt werden, die steuern, wie der Agent Aufgaben durchdenkt, Tools auswählt und Aktionen in der korrekten Reihenfolge ausführt. Darüber hinaus lassen sich Budgets, Zeitlimits und Token-Limits definieren.

- Access: Hier legen wir fest, welche Rollen in welchem Umfang auf den Agenten zugreifen dürfen.

Damit steht ein Agent zur Verfügung, der strukturierte und unstrukturierte Datenquellen verarbeitet, diese semantisch interpretiert und auf Basis der zugänglichen Daten kontextbezogene Anfragen beantwortet.

Testfrage und Ergebnis

Um den von uns erstellten Agenten zu testen, haben wir ihm folgende Frage gestellt:

„Haben wir das CO₂-Reduktionsziel für 2024 im Vergleich zur Referenz aus 2023 erreicht? In welchem Umfang wurde das Ziel über- oder unterschritten?“

Die Antwort wurde im folgenden Video dargestellt:

Wir erhalten unsere Frage sowohl grafisch beantwortet als auch ausführlich erläutert. Snowflake Cortex Intelligence ermöglicht dabei tiefe Einblicke in die von der KI erzeugten Grafiken und Antworten.

Gehen wir den Prozess einmal von Anfang an durch:

- Der Agent führt uns Schritt für Schritt durch seine Denkprozesse. Er entscheidet selbstständig, auf welche Datenquellen er zugreift und welche Services er basierend auf den von uns bereitgestellten Informationen nutzt. Dabei interpretiert und versteht er sowohl strukturierte als auch unstrukturierte Daten.

- Für strukturierte Daten generiert der Cortex Analyst automatisch das passende SQL und führt es aus. Unstrukturierte Daten werden über den Cortex Search Service analysiert, der dafür Vector Search verwendet.

- Aus dem generierten SQL können wir jederzeit nachvollziehen, welche Logik der Agent anwendet. Sobald die Abfrageergebnisse vorliegen, wertet der Agent sie aus und präsentiert uns die finale Antwort, ergänzt durch eine passende grafische Darstellung.

Der Agent liefert uns also nicht nur Ergebnisse, sondern legt auch seinen gesamten Lösungsweg offen. Dadurch bleibt sein Vorgehen vollständig transparent und gut nachvollziehbar.

Weitere Möglichkeiten die Snowflake Intelligence bietet

Über die bereits beschriebenen Funktionalitäten hinaus haben Snowflake Intelligence Agents die Möglichkeit, Daten über das semantische Modell aus dem Snowflake Marketplace zu beziehen. Zusätzlich können sie Dashboards und KPIs aus Tableau interpretieren und nutzen sowie Informationen aus Partnerquellen wie Salesforce auslesen. Darüber hinaus sind Snowflake Intelligence Agents in der Lage, sowohl Funktionen als auch Prozeduren auszuführen, wodurch sich beispielsweise automatisch E-Mails versenden lassen.

Fazit

Die Implementierung von Snowflake Intelligence zeigt, wie sich KI-native Funktionen direkt innerhalb der Datenplattform nutzen lassen, ohne zusätzliche Infrastruktur oder komplexe Integrationswege aufzubauen. Durch die Kombination von Cortex Analyst für strukturierte Daten und dem Cortex Search Service für unstrukturierte Dokumente entsteht ein zentraler Agent, der Datenquellen versteht, semantisch interpretiert und in natürlicher Sprache zugänglich macht. Damit können Mitarbeitende ohne SQL-Kenntnisse oder Analysewerkzeuge fundierte Fragestellungen beantworten und datenbasierte Entscheidungen treffen.

Probiert Snowflake Intelligence einfach selbst mit euren eigenen Daten aus. Erste kleine Experimente zeigen schnell, wie viel Potenzial in den neuen Funktionen steckt.

Wir unterstützen euch!

Erlebt, wie Snowflake Intelligence eure Datenanalyse revolutioniert. Unsere Fachleute unterstützen euch beim Einsatz von Snowflake Intelligence - für schnellere Insights, fundierte Entscheidungen und echte Datendemokratie.