29. April 2021 von Ralf Schmidt

Fallen der Datenvisualisierung – Teil 2: Was uns Datenvisualisierungen über uns selbst verraten

Stellt euch folgende Situation vor: Ihr habt gerade einen Schläger und einen Ball gekauft – für zusammen 1,10 €. Wenn der Schläger 1 € teurer ist als der Ball, wie teuer ist dann der Ball?

Wenn du intuitiv auf die Antwort 10 Cent kommst, bist du in guter Gesellschaft! Mehr als 50 % der Teilnehmer einer Studie von Shane Frederick antwortete mit dieser, leider falschen Antwort. Richtig ist: 5 Cent.

Ihr fragt euch, was das mit Datenvisualisierung zu tun hat? Das erkläre ich nach einem kurzen Rückblick.

Im ersten Teil dieser Serie habe ich häufige Fehler bei der Darstellung von Daten beschrieben und damit einen anschaulichen Einstieg ins Thema «Daten» gefunden. Sie sind omnipräsent und wir haben sie zu einem zentralen Element unserer Wirtschaft gemacht in unserem Bemühen, die Komplexität der verfügbaren Datenströme greifbar zu machen, um daraus neue Erkenntnisse zu kondensieren. Doch der Weg dahin ist steinig und lang!

Betrachtet ihr nur einmal die Datenbeschaffung und ihre Integration: Selbst das überschaubare Beispiel eines Logistikunternehmens, das gern automatisiert die Routen seiner Fahrzeuge optimieren möchte, wird schnell sehr komplex. Standort- und Verkehrsdaten müssen in Echtzeit abgefragt, Straßeninformationen mit zusätzlichen Informationen wie topographischen Daten angereichert und alle Datensätze in Übereinstimmung gebracht werden. Ähnliche Herausforderungen sind auch mit der Datenvalidierung, ihrer Aufbereitung oder auch der Analyse der Daten verbunden – und sie alle sind es wert, genauer beleuchtet zu werden.

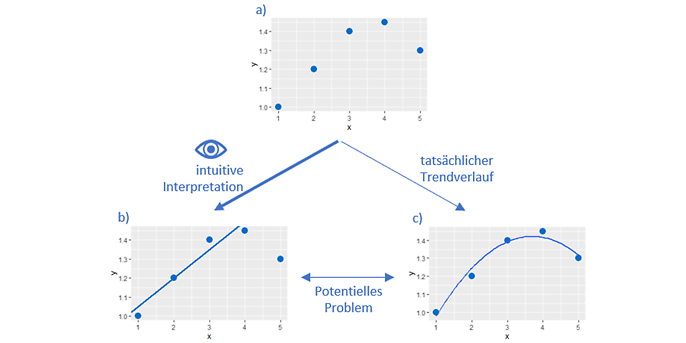

Der entscheidende Schritt ist es aber letztlich, die herausgearbeiteten Informationen zu interpretieren – was oftmals wiederum über Visualisierungen geschieht und uns direkt zum Kern dieses Beitrags bringt. Dieses Mal liegt der Fokus darauf, dass die Betrachtung einer Darstellung unweigerlich einer Interpretation gleichkommt und dass dieser Gleichklang zu Problemen führen kann.

Das langsame und das schnelle System

Die Erklärung, warum es Probleme mit Aufgaben wie der anfänglich gestellten gibt, beantwortet gleichzeitig die Frage, worin die Verbindung zur Datenvisualisierung, besteht. Der Nobelpreisträger Daniel Kahneman hat sehr anschaulich zwei «Arbeitsweisen» unseres Gehirns beschrieben: die Arbeit des schnellen Systems und die des langsamen, logisch denkenden Systems. Das schnelle hilft uns, effizient auf die ständig auf uns einwirkenden Reize zu reagieren und unterbewusst Schlüsse daraus zu ziehen. Dieses System unterliegt jedoch kognitiven Verzerrungen, die «aufwendig» vom langsamen System korrigiert werden müssen. Weil auch Datenvisualisierungen sofort unterbewusst vom schnellen System interpretiert werden, ist es ungemein wichtig, diesen Zusammenhang vor Augen zu haben – um gegebenenfalls aktiv «mit Hilfe» des zwar langsamen, aber reflektierenden Systems zu einer logisch schlüssigen Interpretation der Daten zu gelangen. Die folgenden Beispiele sollen euch weiter sensibilisieren und bei euch ein erhöhtes Bewusstsein über die Unschärfen der eigenen Schlussketten erzeugen.

Und das kann durchaus hilfreich sein. Denn oft genug gestatten Darstellungen gar keine fundierte Schlussfolgerung – suggerieren sie jedoch und verlangen dem Betrachtenden höchste Konzentration ab.

Verwirrung mal Pi zum Quadrat

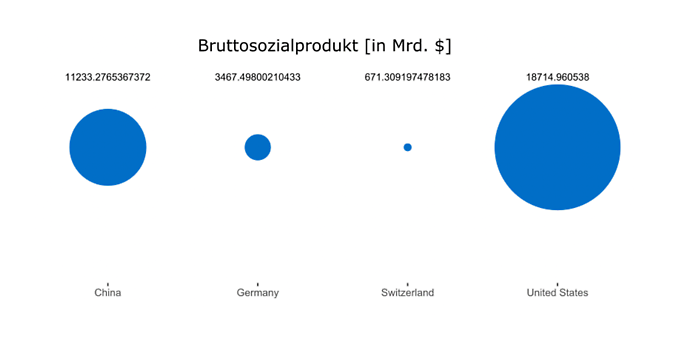

Ein gutes Beispiel für eine Visualisierung, die ihre Intention «verdeckt» vermittelt, ist die folgende Abbildung des Bruttosozialprodukts verschiedener Länder 2016 (die tatsächlich von offizieller Seite so verwendet wurde).

Ein beeindruckend großer Kreis verdeutlicht die Stärke der US-amerikanischen Volkswirtschaft im Vergleich zu den drei anderen Nationen. Er scheint zu rufen: «Die konkreten Werte kannst du vernachlässigen! Du wirst doch wohl noch verschiedene Kreise vergleichen können.»

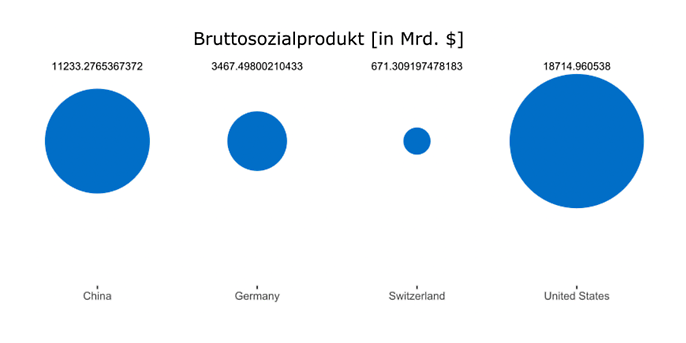

Ja, kann ich! Aber leider nicht so geschickt, dass ich sofort sehe, wie die verschiedenen Kreise skaliert wurden. In diesem Fall wurde nämlich der Radius jedes Kreises entsprechend der Wirtschaftsleistung skaliert. Das ist eine wichtige Information, wie die folgende Abbildung verdeutlicht. Denn die gleichen Zahlen führen zu einem anderen Bild, wenn die Fläche des Kreises und nicht sein Radius skaliert wird.

Nun sind die Kreise in ihrer Größe deutlich näher beieinander und der Unterschied zwischen den Ländern wirkt dadurch geringer. Natürlich ist nichts falsch daran, verschiedene Eigenschaften - etwa Radius oder Fläche zur Skalierung zu nutzen. Es veranschaulicht nur sehr gut, wie leicht unser erster Eindruck von der Darstellung und nicht von den eigentlichen Zahlen geprägt wird, da das schnelle System uns bestmöglich zu unterstützen versucht.

Durch die Brille des Puristen, der in erster Linie die verständliche und klare Vermittlung der Daten im Blick hat, stellt sich die berechtigte Frage: Warum sollten die Daten überhaupt als Kreise dargestellt werden? Wie schon im letzten Teil gesehen, sind Kreise nicht unsere grösste Stärke – weder, wenn es darum geht, Winkel einzuschätzen, noch, wenn die Fläche als Vergleichs-Rahmen für die Werte genutzt wird. Wie so oft lautet die Antwort: «Google…» nein, «a barplot is your friend.»

#showyourdata

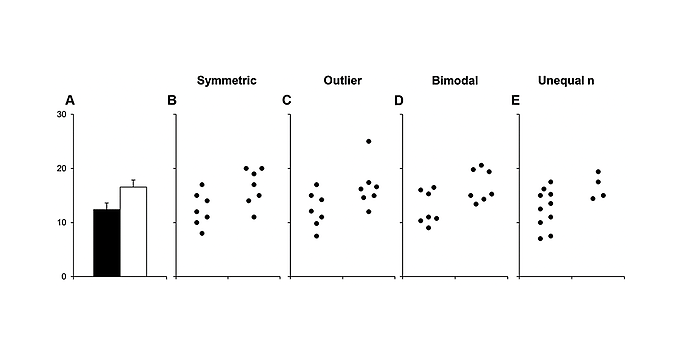

Auch Balkendiagramme haben ihre Limitationen. Besonders dann, wenn sie keine reinen Werte, sondern Maßzahlen - etwa Median oder Mittelwert - abbilden und mit Fehlerbalken versehen sind. Dann steht jeder Balken repräsentativ für die zugrundeliegende Verteilung der Datenpunkte, was problematisch sein kann, wie diese Abbildung aus einem wissenschaftlichen Artikel zeigt:

Die Höhe der zwei Balken in Teilbild A zeigt den Mittelwert der jeweiligen Verteilung an. Abschnitte B bis E machen jedoch sehr klar deutlich, dass diese Mittelwerte (und auch die zugehörigen Fehlerbalken) durch ganz verschiedene Datenwolken erzeugt werden können. Die einzelnen Datenpunkte können B) symmetrisch um den Mittelwert verteilt sein, C) Ausreisser, die den Mittelwert stark beeinflussen, enthalten, D) bimodal (oder natürlich auch multi-modal) in abgegrenzten Wertebereichen auftreten oder E) in ihrer Anzahl stark zwischen den Vergleichsverteilungen variieren.

All diese Aspekte spielen bei der Interpretation der Daten eine zentrale Rolle, werden jedoch durch die Darstellung als Balken unsichtbar. Dem Betrachtenden, dem nur Teilbild A zur Verfügung steht, bleibt die zugrunde liegende Wahrheit über die Verteilungen verborgen; stattdessen gewinnt die Aussage, dass beide Mittelwerte signifikante Unterschiede aufweisen, an Gewicht.

Ganz grundsätzlich gilt: Wann immer es möglich ist, sollten man sich alle Datenpunkte anschauen! Es erlaubt einem, seine eigenen Schlüsse zu ziehen, bevor irgendwelche Balken die eigene «Interpretationsmachine» in Gang gesetzt haben.

Fazit

Gute Darstellungen sind keine Selbstverständlichkeit und sollten daher auch nicht vorausgesetzt werden. Egal ob durch bewusste oder unbewusste Entscheidungen kann eine Visualisierung das Urteil über die gezeigten Daten beeinflussen und somit weitreichende Konsequenzen haben. Dieser Verantwortung von Darstellungen sind sich vor allem Betrachtende oft nicht bewusst und konsumieren die gegebenen Informationen vielmehr als sie wirklich bewusst einzuordnen. Doch in Anbetracht der zentralen Rolle, die Daten in unserer Gesellschaft spielen, sollten wir uns bei ihrer Interpretation die Zeit nehmen, unser langsames System zu aktivieren.

Natürlich ist die Datenvisualisierung nur ein Aspekt ihrer Interpretation. Und der Pfad, den wir mit den gezeigten Beispielen betreten haben, führt geradewegs hinein in die Unbequemlichkeiten der Statistik. Wer es sich trotzdem gern dort gemütlich machen will, kann anhand des Simpson-Paradoxons erstaunliche Ergebnisse eigentlich einfacher Aggregationen entdecken oder sich von Tyler Vigen eindrücklich zeigen lassen, dass der Margarine-Konsum die Scheidungsrate erklären kann – wenn man nur bereit ist, Korrelation und Kausalität gleichzusetzen. Ihr seht , das Ende dieses Beitrag ist erst der Anfang unserer Arbeit, ein besseres Verständnis für die Interpretation von Daten zu entwickeln. Doch wenn wir es schaffen, wachsam zu sein, haben wir schon den wichtigsten Schritt gemeistert.

Und können diese Wachsamkeit gleich an anderer Stelle einsetzen. Im nächsten Beitrag will ich auf das Problem moderner KI-Ansätze eingehen, die so viele Input-Daten benötigen, dass es unmöglich ist, diese noch strukturiert zu kuratieren – und damit nicht immer klar ist, worauf der Algorithmus eigentlich gerade trainiert wird.

Ihr möchter gern mehr über spanneden Themen aus der adesso-Welt erfahren? Dann werft auch einen Blick in unsere bisher erschienenen Blog-Beiträge.

Weitere Teile dieser Blog-Serie