17. August 2023 von Mykola Zubok

Offene Tabellenformate in der modernen Datenanalyselandschaft

In der sich ständig weiterentwickelnden Landschaft der Big-Data-Verarbeitung und -Analyse haben sich Apache Hudi, Iceberg und Delta Lake als leistungsstarke Werkzeuge erwiesen, die die Art und Weise, wie moderne Datenplattformen mit Datenmanagement und -analyse umgehen, revolutionieren. Jede dieser Technologien bietet eine Reihe einzigartiger Funktionen und Möglichkeiten zur Bewältigung der Herausforderungen, die mit der Verarbeitung großer Datenmengen verbunden sind.

In meinem Blog-Beitrag werde ich auf die Kernfunktionen dieser Datentypen eingehen und ihre jeweiligen Stärken und Anwendungsmöglichkeiten hervorheben. Indem ich erläutere, wie sich diese innovativen Lösungen ergänzen und voneinander unterscheiden, werde ich ihre optimale Nutzung beim Aufbau moderner, robuster und effizienter Datenplattformen beleuchten.

Definitionen

Delta Lake

Delta Lake ist eine leistungsstarke Open-Source-Speicherschicht, die entwickelt wurde, um die Fähigkeiten bestehender Data-Lake-Infrastrukturen zu erweitern, die in der Regel auf Objektspeichern wie Azure Blob Storage aufbauen. Durch das Hinzufügen von Funktionen wie ACID-Transaktionen und -Versionierung zu den in diesen Systemen gespeicherten Daten ermöglicht Delta Lake Dateningenieurinnen und -ingenieuren sowie Datenwissenschaftlerinnen und -wissenschaftlern den Aufbau von Datenpipelines und Data Lakes, die nicht nur hoch skalierbar, sondern auch äußerst zuverlässig sind. Diese Kombination aus Zuverlässigkeit und Skalierbarkeit macht Delta Lake zu einem wertvollen Werkzeug für Unternehmen, die ihr Datenmanagement und ihre Analyseprozesse optimieren wollen.

Iceberg

Iceberg zielt als Open-Source-Tabellenformat darauf ab, den effizienten und skalierbaren Zugriff auf umfangreiche Datensätze in Data Lakes zu erleichtern. Erreicht wird dies durch ein Tabellenschema, das sich nahtlos in gängige Datenverarbeitungstools wie Apache Spark integrieren lässt. Darüber hinaus bietet Iceberg wichtige Funktionen wie ACID-Transaktionen, Versionierung sowie Datenevolution, die den Nutzen für Datentechnikerinnen und -techniker sowie für Datenanalystinnen und -analysten weiter erhöhen. Mit diesen Funktionen ermöglicht Iceberg den Anwenderinnen und Anwendern eine effektive Arbeit mit großen Datensätzen, während gleichzeitig die Datenintegrität gewährleistet wird und Änderungen der Datenstruktur im Laufe der Zeit berücksichtigt werden.

Hudi

Hadoop Upserts Deletes and Incrementals – kurz Hudi – ist ein Open-Source-Framework, das auf die Speicherung und Verarbeitung von Daten zugeschnitten ist. Sein Hauptaugenmerk liegt darauf, Echtzeitdatenzugriffe und -analysen zu ermöglichen. Das Framework ist mit wesentlichen Funktionen wie ACID-Transaktionen, inkrementeller Datenverarbeitung und effizienter Datenindizierung ausgestattet. Diese Eigenschaften machen Hudi zu einer perfekten Lösung für Anwendungsfälle, die Streaming-Datenverarbeitung und Echtzeitanalysen beinhalten. Mit Hudi können Unternehmen ihre Daten effizient in Echtzeit verwalten und analysieren, was schnellere Erkenntnisse und reaktionsschnellere Entscheidungsprozesse ermöglicht.

Gemeinsame Merkmale

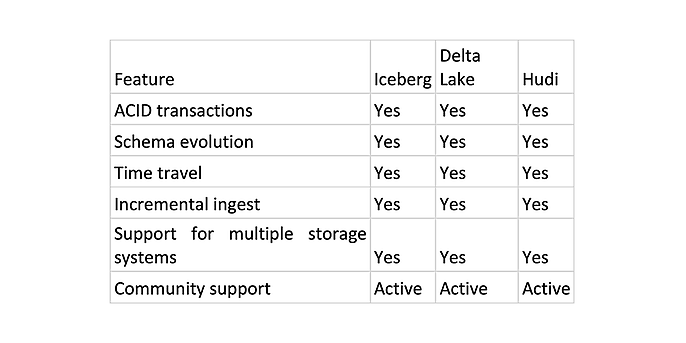

Die Datentypen haben gemeinsame Merkmale und in einigen Anwendungsfällen können sie austauschbar sein. In der folgenden Tabelle sind die gemeinsamen Hauptfunktionen dargestellt.

Gemeinsame Hauptfunktionen von Iceberg, Delta Lake und Hudi

- ACID transactions stellen sicher, dass Ihre Daten immer konsistent sind, auch bei Ausfällen. Dies ist wichtig für Data Lakes, die für geschäftskritische Anwendungen genutzt werden.

- Schema evolution ermöglicht es, das Schema von Data-Lake-Tabellen zu ändern, ohne die Tabellen neu erstellen zu müssen. Dies ist wichtig für Data Lakes, die für die Speicherung historischer Daten verwendet werden.

- Time travel ermöglicht es, historische Versionen von Data-Lake-Tabellen abzurufen. Dies ist wichtig für Data Lakes, die für Audits und Compliance-Zwecke verwendet werden.

- Incremental ingest ermöglicht es, neue Daten in Data-Lake-Tabellen zu laden, ohne den gesamten Datensatz erneut verarbeiten zu müssen. Dies ist wichtig für Data Lakes, die für die Aufnahme großer Mengen von Streaming-Daten verwendet werden.

- Support for multiple storage systems ermöglicht es, Data-Lake-Tabellen in einer Vielzahl von Speichersystemen speichern – zum Beispiel Amazon S3, Azure Blob Storage und Google Cloud Storage. Dies gibt die Flexibilität, das Speichersystem zu wählen, das Ihren Anforderungen am besten entspricht.

- Community support bedeutet, dass viele Menschen das Projekt nutzen und etwas zu ihm beitragen. So ist es wahrscheinlicher, dass man Hilfe findet, wenn man sie braucht.

Leistung

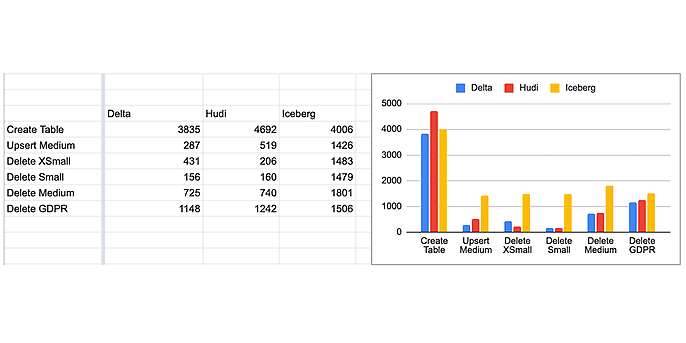

Entsprechend den Benchmarks (https://brooklyndata.co/blog/benchmarking-open-table-formats, https://github.com/brooklyn-data/delta/pull/2) liegen folgende Leistungswerte vor:

Leistungsvergleich, Quelle: https://github.com/brooklyn-data/delta/pull/2

Wie wir im obigen Ergebnis sehen können, zeigt Delta Lake im Allgemeinen eine bessere Leistung als Iceberg und Hudi. Beim Vergleich der Leistung sollten wir jedoch berücksichtigen, dass Delta und Iceberg für reine Append Workloads optimiert sind, während Hudi standardmäßig für veränderliche Workloads optimiert ist. Hudi verwendet standardmäßig einen Upsert-Schreibmodus, der im Vergleich zu Inserts natürlich einen Schreib-Overhead hat. Ohne diese Hintergrundinformation ist es so, als würde man Äpfel mit Birnen vergleichen.

Integration in verschiedene Plattformen

Wenn man die Auswirkungen der Harmonisierung von Datentypen versteht, kann man das wahre Potenzial von Cloud-basierten Analysen freisetzen, Daten-Workflows rationalisieren und eine bessere Zusammenarbeit zwischen einzelnen Teams fördern.

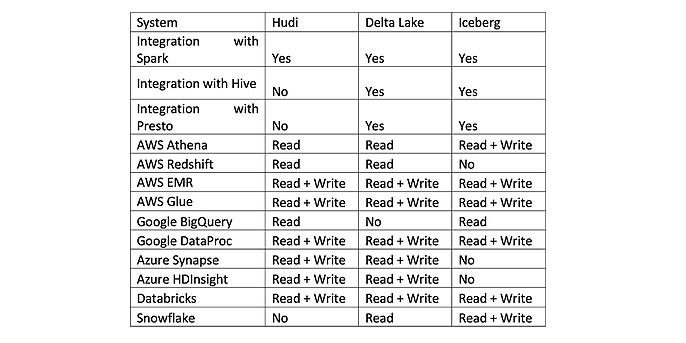

Vergleich: Diese Systeme unterstützen Hudi, Delta Lake und Iceberg

Wie ihr seht, unterstützt nicht jede Plattform alle Datentypen. Google BigQuery, eine beliebte Cloud-basierte Analyseplattform, verfügt beispielsweise nicht über eine direkte Integration von Delta Lake. Ebenso bieten Amazon Redshift und Azure Synapse Analytics keine integrierte Unterstützung für Iceberg. Außerdem bietet Snowflake, das für seine Cloud-basierten Data-Warehousing-Funktionen bekannt ist, keine native Unterstützung für Apache Hudi.

Fazit: Was man verwenden sollte

Für den Aufbau eines Data Lake solltet ihr Delta Lake und Hudi aufgrund ihrer Kompatibilität mit Data-Lake-Infrastrukturen wie S3 oder Azure Storage in Betracht ziehen. Für ein Data Warehouse ist Iceberg eine bevorzugte Option, die sich durch eine effiziente Abfrageleistung auszeichnet. Für Echtzeit-Datenzugriff und -Analysen ist Hudi die ideale Wahl. Wenn ihr Stapelverarbeitung benötigt, bieten Delta Lake und Iceberg eine robuste Unterstützung für Datenpipelines. Alle drei Formate – Delta Lake, Hudi und Iceberg – bieten ACID-Transaktionen und Datenversionierung. Delta Lake zeichnet sich allerdings durch seine außergewöhnliche Unterstützung in diesen Bereichen besonders aus. Wenn es um sich im Laufe der Zeit verändernde Datenstrukturen geht, ist Iceberg aufgrund seiner robusten Unterstützung für Schemaentwicklung und Versionierung die optimale Wahl.

Delta Lake, Hudi und Iceberg bieten eine solide Integration mit weit verbreiteten Datenverarbeitungstools wie Apache Spark, Python oder Hadoop. Es ist jedoch wichtig, den Tech-Stack und die Zukunftspläne des Projekts sorgfältig zu prüfen, da einige große Anbieter möglicherweise bestimmte Formate nicht unterstützen.