29. September 2023 von Sezen Ipek und Stefan Mönk

Agilität trifft auf Data Science: Erfolgversprechende Ansätze für DS-Projekte

Künstliche Intelligenz (KI), maschinelles Lernen (ML) und Deep Learning (DL), Data Analytics oder Data Analysis? Und was hat es eigentlich mit Agilität auf sich? Dieser Blog-Beitrag schafft Klarheit. Agilität und Data Science haben eines gemeinsam: Beide Disziplinen haben in den vergangenen Jahren enorm an Bedeutung gewonnen. Der Einsatz agiler Methoden und Rahmenwerke kann einen entscheidenden Erfolgsfaktor für Unternehmen darstellen. In diesem sowie den folgenden Blog-Beiträgen werden wir uns im Kern mit der Frage beschäftigen, ob und wie agile Vorgehensweisen in die Welt der Data Science integriert werden könnten. Zuerst verschaffen wir euch aber einen Überblick über wichtige Grundlagen rund um Data Science und Agilität.

Data Science von Softwareentwicklung differenzieren

Data Science sollte nicht mit der reinen Softwareentwicklung gleichgesetzt werden. Softwareentwicklung umfasst die Entwicklung von Anwendungen oder Systemen, die spezifische Anforderungen erfüllen. Es geht um die Programmierung eines Codes, der auf unterschiedlichen Plattformen läuft und gewartet wird. Data Science wiederum ist auf die Analyse von Daten zur Gewinnung von Erkenntnissen und zur Modellierung von Mustern ausgerichtet. Dies erfordert eine experimentelle Arbeitsweise, weil im vornherein keine Annahmen über Daten und mögliche Ergebnisse getroffen werden können. Auch das Deployment von Softwareprogrammen und Machine-Learning-Modellen muss differenziert betrachtet werden, da Softwareprogramme weitestgehend statisch sind, während Machine-Learning-Modelle sich kontinuierlich ändern und neue Daten lernen müssen. Data Science und Data Mining kommen schließlich der Forschung und Entwicklung näher als dem Engineering. Dies wird auch an CRISP-DM erkennbar, da es auf der Erkundung neuer Ansätze und nicht auf dem Design von Software basiert. Wer sich jetzt fragt, was genau CRISP-DM sein soll, der darf sich auf die folgenden Absätze freuen.

DS-Begrifflichkeiten abgrenzen

Bevor wir in die Details der agilen Softwareentwicklung in Data Science eintauchen, ist es wichtig, die verschiedenen Begriffe abzugrenzen. Künstliche Intelligenz, Machine Learning, Deep Learning, Data Analytics und Data Analysis sind eng miteinander verbunden, aber sie haben jeweils ihre eigenen Merkmale und Anwendungen. Deshalb werfen wir einen kurzen Blick auf jede dieser Disziplinen und zeige euch, wie diese innerhalb Data Science zu verstehen sind.

Data Science

Data Science wird als interdisziplinäre angewandte Wissenschaft definiert. Ziel ist es, Wissen aus Daten zu gewinnen, um Entscheidungsprozesse zu unterstützen oder Unternehmensprozesse zu optimieren. Data Science wird bestimmt als die wissenschaftliche Untersuchung der Erstellung, Validierung und Transformation von Daten, um Erkenntnisse aus ihnen zu gewinnen. Zudem nutzt Data Science wissenschaftliche Prinzipien, um aus Daten Bedeutung zu generieren, und setzt Machine Learning und Algorithmen ein, um Informationen aus großen Datensätzen zu extrahieren und zu verwalten.

Entsprechend der Definition nutzt ein Data Scientist wissenschaftliche Methoden aus Bereichen der Mathematik, Statistik, Stochastik und Informatik. Unter den Zielen sind neben der Wissensgenerierung aus Daten die Ableitung von Handlungsempfehlungen, die Unterstützung von Entscheidungsfindungen und die Optimierung sowie Automatisierung von Unternehmensprozessen. Außerdem wird die Erstellung von Prognosen und Vorhersagen für zukünftige Ereignisse erzielt.

Künstliche Intelligenz

Das Gebiet der Künstlichen Intelligenz (KI) ist sehr vielfältig und stark interdisziplinär. Für den Begriff KI (oder auch häufig AI genannt) gibt es unterschiedliche Definitionen. Den Definitionen ist gemeinsam, dass es in der KI um die Entwicklung von Computerprogrammen oder Maschinen geht, deren Verhalten als „intelligent“ bezeichnet werden kann.

Zwischen den Begriffen Data Science und KI besteht eine starke Verknüpfung. Data Science wird als interdisziplinäres Forschungsfeld gesehen, das verschiedene Prozesse und Methoden nutzt, um aus Daten neues Wissen zu generieren. Die Prozesse umfassen Datenaufbereitung, -analyse, -visualisierung und -vorhersage. Der Unterschied ist, dass KI sich auf die Erstellung von Modellen fokussiert. Diese Modelle können in Data-Science-Projekten verwendet werden, um bestimmte Fragestellungen zu beantworten.

Machine Learning & Deep Learning

Maschinelles Lernen (Maschinenlernen oder Machine Learning) und dessen besondere Ausprägung Deep Learning sind Disziplinen, die zur KI gehören. Machine Learning bezieht sich auf die künstliche Generierung von Wissen aus Erfahrung, insbesondere aus vorhandenen Trainingsdaten. Durch Machine Learning werden Muster abgeleitet und mathematisch beschrieben, indem es sich aus einer Vielzahl an Methoden im Bereich überwachtes (Supervised Learning), unüberwachtes (Unsupervised Learning) und Verstärkungslernen (Reinforcement Learning) bedient. Mit diesen ist es möglich, Modelle zu erlernen sowie Auswertungen und Verarbeitungen komplexer Systeme, wie natürlicher Sprache oder Bilderkennung, zu ermöglichen.

Data Analytics & Data Analysis

Data Analytics wird als ein Teilgebiet von Data Science betrachtet, bei dem es um die Sammlung, Speicherung, Verarbeitung und Analyse von Daten geht, um strategische und geschäftsrelevante Erkenntnisse aus ihnen zu gewinnen. Data Analytics befasst sich mit der Generierung von Erkenntnissen aus Daten in deskriptiver Form. Data Science und Data Analytics teilen sich Methoden und Prozesse, allerdings sind in Data Science noch weitere ergänzende Methoden vorhanden.

Die Data Analysis ist als Unterkategorie der Data Analytics zu verstehen und umfasst die Analyse einzelner Datenmengen, um Erkenntnisse aus ihnen zu gewinnen. Der Unterschied zwischen Data Analytics und Data Analysis wird durch deren Zielsetzungen deutlich. Während im Bereich der Data Analysis Erkenntnisse aus historischen Daten gewonnen und diese interpretiert sowie visualisiert werden, geht es bei Data Analytics mehr um die Vorhersage von zukünftigen Ereignissen und um die Ableitung von Handlungsempfehlungen.

DS-Methoden kennen

Data Science erfordert eine systematische Vorgehensweise und einen klaren Prozess, in dem Aufgaben strukturiert und Phasen klar voneinander abgetrennt sind. Ein solcher Prozess ist notwendig, um Data Scientists und anderen Beteiligten einen Handlungsrahmen vorzugeben, um datenanalytische Aufgabenstellungen zu strukturieren und potenziellen Herausforderungen zu begegnen. CRISP-DM und CRISP-ML(Q) sind verbreitete Prozessmodelle, die im Data-Science-Bereich zum Einsatz kommen.

Cross Industry Standard Process for Data Mining – CRISP-DM

Um aus großen Datenmengen Muster und Modelle zu entwickeln, damit im Anschluss Wissen aus Daten extrahiert werden kann, bedarf es eines systematischen, in Phasen unterteilten Prozesses. Das am weitesten verbreitete Modell für Data-Science-Projekte ist der CRISP-DM.

Data Mining (also Datenmustererkennung) wird als Teilbereich der Data Science gesehen und umfasst statistische Methoden und Algorithmen, um Erkenntnisse aus Daten zu extrahieren. Der CRISP-DM-Ansatz hat einen erheblichen Beitrag zur Etablierung von iterativen und agilen Vorgehensweisen in Data-Science-Projekten geleistet.

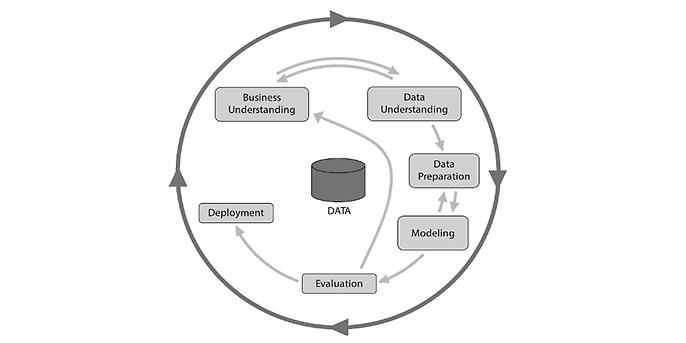

CRISP-DM-Phasen, Quelle Haneke et al., 2021: 9

CRISP-DM-Phasen

CRISP-DM ist in sechs Phasen unterteilt, dabei handelt es sich bei der Vorgehensweise um einen iterativen und zyklischen Prozess:

- Business Understanding: In dieser Phase wird das fachliche Verständnis geschaffen und der Istzustand sowie die Projektziele werden identifiziert.

- Data Understanding: Hier geht es um die Identifikation und um das Verständnis der Daten und Datenquellen. Dies umfasst die Durchführung einer explorativen Datenanalyse.

- Data Preparation: Eine Datenaufbereitung ist wichtig, um Daten für das Training der Modelle zu nutzen.

- Modeling: In der Modeling-Phase lernt das Modell mittels Data-Mining-Algorithmen wie Klassifikations-, Cluster- oder Regressionsanalysen.

- Evaluation: Die Ergebnisse des Modells werden in dieser Phase ausgewertet.

- Deployment: Hierbei erfolgen die Operationalisierung der Ergebnisse sowie die Überwachung der Betriebsbedingungen.

Cross Industry Standard Process for Machine Learning – CRISP-ML(Q)

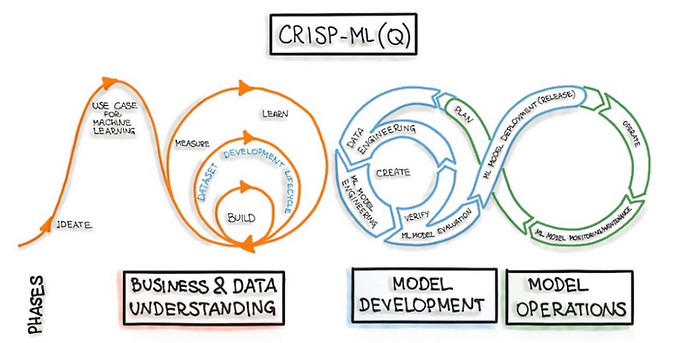

Das CRISP-ML(Q) kann als eine Erweiterung des CRISP-DM-Ansatzes betrachtet werden und sorgt dafür, dass die Prinzipien von Machine Learning Operations (MLOps) eingehalten und umgesetzt werden. MLOps sind ein iterativer Prozess, der als wichtige Komponente für den Erfolg von Data-Science-Projekten angesehen wird. Mit MLOps wird in Data-Science-, KI- und Machine-Learning-Projekten Wert generiert und potenzielle Risiken werden minimiert. Ziel ist die Standardisierung des Lebenszyklus von Machine-Learning-Modellen. Der CRISP-ML(Q)-Ansatz wurde für die Entwicklung von maschinellen Anwendungen konzipiert, in denen ein Machine-Learning-Modell zum Einsatz kommt. CRISP-ML(Q) ist, wie CRISP-DM, ein iteratives Modell, das aus mehreren Phasen besteht.

Das Deployment von Softwareprogrammen und Machine-Learning-Modellen muss differenziert betrachtet werden, da Softwareprogramme weitestgehend statisch sind, während Machine-Learning-Modelle sich kontinuierlich ändern und neue Daten lernen müssen. Die Modellumgebung unterliegt einer höheren Komplexität und erwartet durch den Einsatz von MLOps eine Risikobewertung und -reduktion.

CRISP-ML(Q)

Ausblick

Data Science und Agilität sind Erfolgsfaktoren der modernen Datenwelt. In diesem Blog-Beitrag wurden Grundlagen rund um Data Science in Verbindung mit Agilität vermittelt. Es ist wichtig zu verstehen, dass Data Science sich von der herkömmlichen Softwareentwicklung unterscheidet und komplexe, experimentelle Arbeit erfordert. Wir haben auch die Begriffe KI, ML, Data Analytics und Data Analysis abgegrenzt, um Klarheit zu schaffen. Prozessmodelle wie CRISP-DM und CRISP-ML(Q) helfen uns, einen systematischen Ansatz zu verfolgen. Doch wie setzen wir agile Vorgehensweisen in DS-Projekten ein? Gibt es Kriterien, die den Einsatz von konkreten agilen Methoden beeinflussen? Sind wir dazu bereit, „wirklich“ agil zu sein? Diese Fragen klären wir in unserem nächsten Blog-Beitrag.